Dans l’univers en pleine mutation de l’intelligence artificielle générative, de nombreux professionnels cherchent à optimiser leur utilisation de ChatGPT. Pourtant, une erreur récurrente sème la confusion : l’attribution de rôles fictifs à l’IA. Dans ce guide, je vous livre un décryptage rigoureux — basé sur des tests concrets et les fondamentaux du prompt engineering — pour comprendre pourquoi cette pratique n’a aucun sens. En mettant l’accent sur une méthode structurée, ancrée dans l’efficacité, je vous montre comment concevoir de vrais prompts efficaces.

La tentation est forte, lorsqu’on rédige un prompt pour ChatGPT, de lui attribuer un rôle comme “expert SEO” ou “recruteur RH”. C’est une pratique fréquente, héritée des banques de prompts en ligne, mais elle repose sur une idée fausse : l’IA ne “devient” pas meilleure en endossant un rôle. Cela peut même nuire à la pertinence des réponses. Ce mythe est sans doute le plus répandu sur le web de tous ceux que nous explorons dans la rurique « le vrai du faux » de ce site. Elle s’est répandu via des raccourcis pédagogiques proposés par des pseudos-experts plus attirés par l’appat du gain que par un travail sérieux, et ignorant tout des vraies logiques du prompt engineering. Résultat : des prompts mal structurés, des réponses floues, une perte d’efficacité. Seule une approche rigoureuse, fondée sur des méthodes robustes, permet d’exploiter pleinement le potentiel de l’IA.

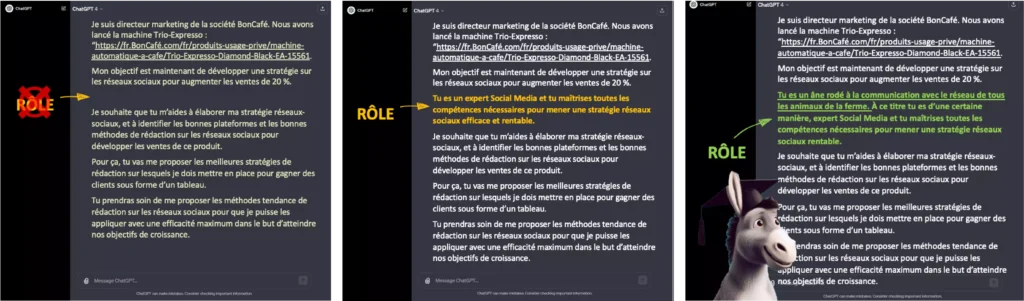

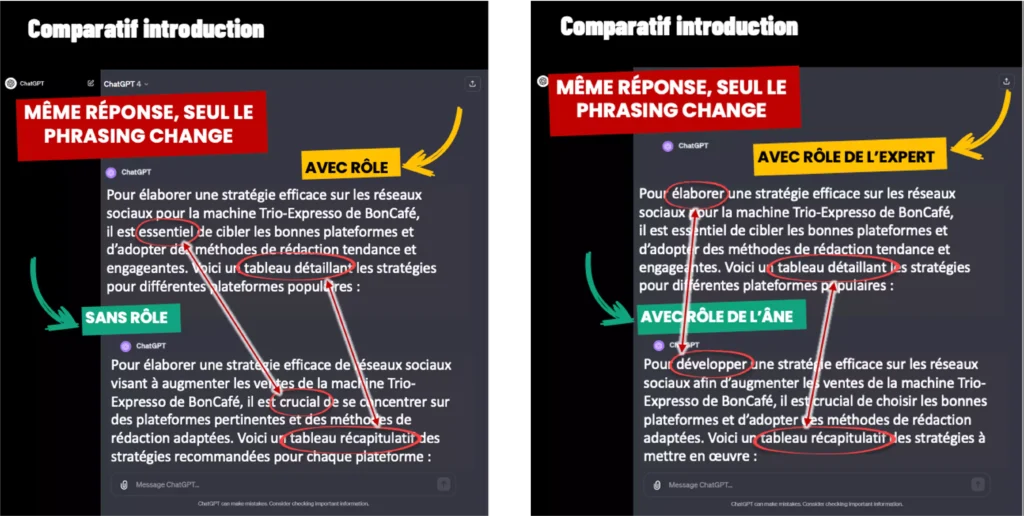

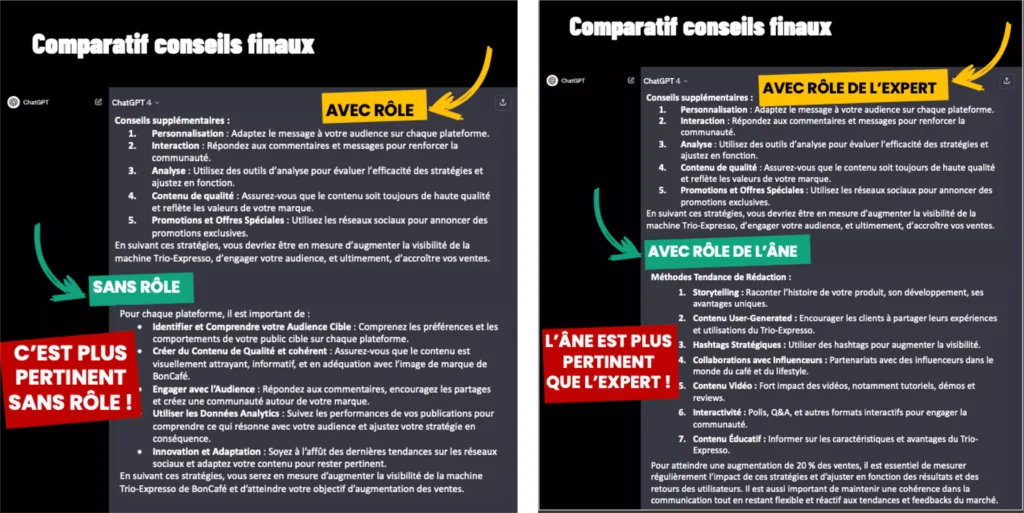

Plusieurs centaines de tests contrôlés ont été réalisés pour mesurer l’effet réel d’un rôle dans un prompt. Le résultat est sans appel : que l’on insère ou non un rôle à ChatGPT, la structure et les catégories de réponses restent identiques. Ce qui varie ? Le style, la nuance de formulation, parfois le ton — jamais le fond. L’un des tests les plus révélateurs portait sur la création d’une campagne marketing. Nous avons comparé un prompt sans rôle, un prompt avec le rôle d’“expert en social media”, et un autre attribuant le rôle… d’un âne. Verdict : la version sans rôle était la plus pertinente, parfois même plus que celle avec le rôle absurde. Preuve que le prompt engineering repose sur la structure, pas sur le théâtre.

Autre exemple : une demande de cours sur le théorème de Pythagore donnait un contenu pédagogique plus clair sans rôle qu’avec “Tu es un professeur de 4e”. Cela prouve que l’attribution de rôle n’améliore pas la qualité intrinsèque des réponses. Cette évidence peut sembler contre-intuitive, pourtant elle s’explique par la nature même du fonctionnement des LLM comme ChatGPT. Le vrai levier d’optimisation réside dans une bonne structuration du prompt, pas dans le rôle fictif. Voilà pourquoi maîtriser le prompt engineering est incontournable ici.

Attribuer un rôle à ChatGPT revient à croire que cela injectera une expertise dans la réponse obtenue. Or cela entre en contradiction totale avec son fonctionnement. ChatGPT est un modèle statistique de langage, non un expert doté d’une biographie ou d’un diplôme. Comme l’explique le MIT Technology Review, GPT-4 ne fait que prédire le mot suivant dans une séquence en s’appuyant sur des matrices d’apprentissage massif). Il ne peut intégrer en une réponse plus de 8 192 tokens, ce qui exclut toute capacité à résumer un ouvrage complet ou à synthétiser des milliers de pages d’expertise.

Un rôle imaginaire comme “médecin-cardiologue” n’augmente donc pas la précision de ses réponses médicales. Par ailleurs, tout rôle rallonge inutilement un prompt, réduisant ainsi la capacité utile de ChatGPT à comprendre et à traiter les instructions essentielles. Face à ce constat, le seul moyen efficace de maximiser la qualité des réponses est de maîtriser le prompt engineering, ce qui revient à structurer chaque prompt avec rigueur, précision et dans les limites de l’architecture du modèle.

Un prompt n’est pas une simple commande : c’est une instruction stratégique, claire, segmentée, complète. À l’image d’un chef confiant une fiche de mission, ChatGPT attend de la précision. Lui attribuer un rôle comme “sois un expert IA” revient à coller une étiquette inutile, souvent contre-productive. À l’inverse, un prompt solide repose sur sept couches (objectif, contexte, cible, etc.) qui rendent la réponse pertinente et évolutive. Cette structuration méthodique incarne l’essence du prompt engineering. On obtient ainsi davantage de précision, de valeur et de cohérence. Un prompt efficace est un plan d’action clair — pas une mise en scène imaginaire.

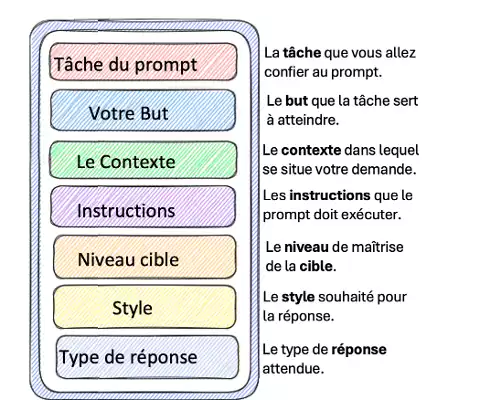

Il existe sept couches qui permettent de concevoir un prompt de manière efficace et pérenne dans le temps. Les voici :

Chacune de ces couches joue un rôle plus important que n’importe quel “rôle fictif” attribué à l’IA. Cette approche en strates constitue le cœur du prompt engineering efficace. C’est cette granularité qui rend le prompt capable de générer du contenu de qualité. Par exemple, pour obtenir un contenu optimisé SEO, je veille à préciser le format, le ton, l’objectif (visibilité sur Google, conversion, fidélisation), tout en insérant les règles du SEO et de l’EEAT à respecter. C’est cette méthode qui permet aux professionnels de maximiser la productivité de leurs contenus générés.

Un prompt efficace ne se limite pas à poser une question : il sert un objectif métier. En SEO, il doit être clair (éviter les ambiguïtés), complet (contexte et attentes), et pensé pour répondre aux critères de performance d’un contenu structuré. Cela implique l’usage de mots clés pertinents, l’alignement sur l’intention utilisateur et des formats propices à l’indexabilité (FAQ, listes, synthèses). Pour rédiger une fiche produit, je précise la catégorie, les caractéristiques, l’intention d’achat, le style SEO. J’exclus les rôles fictifs comme “tu es rédacteur”, qui diluent le fond. Le prompt engineering stratégique produit un contenu plus clair, mieux ciblé, et SEO-compatible.

Cette idée reçue vient d’une mauvaise lecture des documents techniques d’OpenAI, relayée par des formateurs peu familiers de la logique du prompt. Il suffit qu’un blog anglophone évoque le mot “rôle” hors contexte pour que certains en fassent une règle. Pourtant, OpenAI ne recommande pas cette pratique dans l’usage grand public de ChatGPT. Dans son API, “rôle” désigne trois fonctions techniques (user, system, assistant), et non un déguisement comme “sois un dentiste expérimenté”. Ce malentendu a été massivement diffusé sans validation. Encore une fois, seul un prompt engineering rigoureux permet de dépasser les effets de mode pour obtenir des résultats fiables.

En majorité, ce sont des pseudo-formateurs IA ou des créateurs de contenus sur LinkedIn, TikTok ou YouTube. Leur expertise repose souvent sur des prompts copiés traduits depuis des blogs US, comme “You are my expert marketing assistant”, ou des compilations trouvées sur des banques de prompts peu fiables. Ces “experts en prompt engineering” ne testent pas ce qu’ils recommandent. Pire, ils répliquent aveuglément des formats qui ne reposent sur aucun protocole comparatif. Ces pratiques peuvent même amener à des erreurs graves, comme proposer des prompts SEO qui font chuter la lisibilité, ou encore générer des textes mal ciblés. Je souligne ici un vrai risque : la propagation d’incompétence par mimétisme. Voilà pourquoi former les professionnels aux vraies méthodes structurantes de prompt engineering devient également une mission pédagogique urgente.

Attribuer un rôle à ChatGPT, c’est comme déguiser une machine sans conscience. Cela semble crédibiliser le prompt, mais en réalité, cela le rend flou, plus long, et nuit à la clarté. En contexte professionnel, cette pratique produit des contenus génériques, parfois emphatiques, rarement adaptés à leur cible. En SEO, cela se traduit par des blocs peu exploitables. Chaque token gaspillé à “jouer un rôle” rogne sur l’essentiel. Pour gagner en pertinence et en efficacité, mieux vaut structurer son prompt couche par couche, selon les principes du prompt engineering. Cette rigueur renforce la qualité, la scalabilité et la valeur des contenus générés.

Un prompt intégrant un rôle fictif devient aussitôt plus long. Or chaque mot compte : ChatGPT respecte une limite stricte de tokens. Ajouter “Tu es mon expert en contenu digital…” alourdit le prompt de 10 à 15 tokens sans amélioration qualitative. Cela complique la lecture, ralentit la génération et réduit l’adaptabilité. L’IA passe alors plus de temps à adopter un style qu’à produire un raisonnement structuré. Résultat : perte d’efficacité, baisse du ROI, surcharge de relecture. Un prompt mal conçu bloque l’automatisation à grande échelle. Le prompt engineering, en revanche, prône la concision stratégique : chaque mot doit servir l’objectif. Rien ne doit être superflu.

Introduire un rôle modifie la tonalité de la réponse IA. Cela peut déclencher une cascade d’effets : ton trop complexe, autorité artificielle, perte de clarté, voire déconnexion totale de la cible. Un “expert SEO” fictif produit souvent un discours abscons là où l’on attend un langage clair. Parfois, l’IA invente même des faits pour “jouer le rôle”. Résultat : la pertinence chute — ce qu’une stratégie SEO ou marketing ne peut se permettre. Mieux vaut structurer l’intention, définir le niveau de vocabulaire et préciser la cible. Ces éléments, piliers du prompt engineering, garantissent la cohérence des réponses et évitent les dérives stylistiques inutiles.

Le SEO ne tolère ni imprécision ni confusion. Pourtant, les rôles fictifs dans les prompts génèrent souvent des contenus trop génériques, peu scalables, voire contre-productifs. Pour inverser cela, il faut former les équipes au vrai prompt engineering pour le marketing et le SEO. Cette méthode permet de concevoir des contenus clairs, alignés sur les intentions de recherche et la stratégie de mots clés. Un prompt bien structuré produit des résultats jusqu’à trois fois plus pertinents en SEO. Ce n’est pas un luxe, mais un levier de compétitivité. Automatiser ne signifie pas reproduire des erreurs rapidement : cela demande de penser stratégie éditoriale dès la rédaction du prompt.

Former ses équipes à ChatGPT ne se limite pas à expliquer l’interface. Il faut transmettre une vraie méthode, basée sur les 7 couches du prompt, des cas concrets et des exercices pratiques. Dans les formations efficaces, le prompt engineering s’apprend via des modules spécifiques : rédaction SEO, contenu marketing, analyse concurrentielle, etc. Les résultats sont rapides : meilleure productivité, ton éditorial cohérent, ROI optimisé. Au fond, maîtriser le prompt engineering revient à dialoguer intelligemment avec l’IA pour en extraire un maximum de valeur. Pour les entreprises, cette compétence devient stratégique, voire essentielle, dans tous les métiers liés à l’information ou à la production de contenu.

Grâce à un prompt engineering maîtrisé, les bénéfices concrets sont multiples : génération plus rapide de contenus SEO optimisés, cohérence éditoriale entre les productions IA et humaines, capacité à industrialiser la création de contenus sans sacrifier la qualité. Par exemple, une entreprise ayant structuré ses prompts autour du contexte SEO et du type de réponse attendue (FAQ, synthèse, liste à puces) a pu tripler son trafic organique en 90 jours. Cela réduit aussi le temps passé en relecture, améliore la précision des méta-descriptions et optimise la pertinence des balises H1/H2. En d’autres termes, l’automatisation IA performante repose moins sur l’intelligence de ChatGPT que sur l’intelligence du prompt qui le pilote. Le mot clé automatisation IA avec ChatGPT devient ainsi plus qu’un concept : une pratique décisionnelle.

Pour conclure, je tiens à souligner que la maîtrise du prompt engineering ne repose pas sur des rôles ou des mises en scène fictives, mais sur une compréhension fine des mécanismes de l’IA. En tant qu’expert passionné, je l’affirme : c’est la structure claire, la précision lexicale et l’adaptation au contexte qui transforment un prompt ordinaire en levier puissant d’automatisation IA avec ChatGPT. C’est pourquoi je recommande de délaisser les méthodes hasardeuses pour adopter une approche rigoureuse, testée et orientée résultats. En affinant vos prompts, vous gagnerez en pertinence, en productivité et surtout… en impact SEO.

Attribuer un rôle comme par exemple “expert en SEO” à ChatGPT semble séduisant, mais c’est une illusion contre-productive. En réalité, cela surcharge inutilement le prompt et pollue la précision attendue. L’IA ne devient pas experte par simple déclaration : elle reste un système probabiliste de langage. J’ai testé des centaines de variantes avec et sans rôles, et devinez quoi ? Aucune amélioration significative sur la pertinence. Au contraire, cela peut générer du contenu flou, parfois même maladroit. La vraie richesse vient d’une structuration stratégique selon les sept couches du prompt engineering. C’est ce socle méthodique qui garantit la puissance des réponses générées.

Absolument – et je parle d’expérience. En structurant vos prompts suivant les couches clés du prompt engineering (objectif, contexte, style, etc.), chaque réponse IA devient plus ciblée, plus digeste, et surtout parfaitement alignée sur votre stratégie SEO. J’ai observé un net saut qualitatif : meilleures balises H1, contenu rédigé comme un humain, taux de rebond réduit. En éliminant les rôles fictifs, on récupère de la place pour des instructions utiles, comme l’intention utilisateur ou le format attendu (FAQ, liste, synthèse). Bref, pour performer sur Google aujourd’hui, il ne faut pas plus d’IA, mais un meilleur prompt engineering.

Un prompt efficace n’a rien à voir avec un copier-coller de banque de prompts. Il s’agit d’un véritable briefing de production, structuré en sept couches précises : la tâche, l’objectif, le contexte, les instructions détaillées, le niveau de la cible, le style, enfin le format de réponse. Chaque couche joue un rôle crucial. Par exemple, en précisant que je veux “un paragraphe concis à destination de débutants en automatisation IA avec ChatGPT”, je guide la réponse vers l’essentiel. C’est cette méthodologie, fondée sur le prompt engineering, qui vous offre des contenus scalables, clairs et SEO-compatible sans perdre une miette de qualité.

Elle vient d’une mauvaise lecture de la documentation d’OpenAI et d’une interprétation erronée du mot “rôle” dans l’API. Dans l’interface, ça renvoie simplement à un ton ou une fonction (comme “system” ou “assistant”), pas à un diplôme fictif. Hélas, certains formateurs peu rigoureux ont popularisé une sorte de théâtre inutile : “tu es avocat, tu es rédacteur…”. Ces instructions ne changent ni la structure ni la profondeur des réponses. Ce que j’affirme ici est prouvé par tests répétés. Encore une fois, seule une maîtrise rigoureuse du prompt engineering garantit des résultats utiles et exploitables, surtout en contexte professionnel.

Franchement, montrer comment utiliser ChatGPT ne suffit pas. Il faut former les équipes à penser en termes de structure, de contexte et d’intention. Personnellement, je m’appuie sur des études de cas, des prompts réels comparés, et des exercices typés SEO, e-commerce ou stratégie éditoriale. On aborde aussi les limites — comme le plafond de tokens — et les biais à éviter. Résultat : une vraie autonomie des rédacteurs et marketeurs, une meilleure logique dans les briefs, une montée en puissance de la productivité. En entreprise, maîtriser le prompt engineering, c’est transformer un outil curieux en levier stratégique puissant.