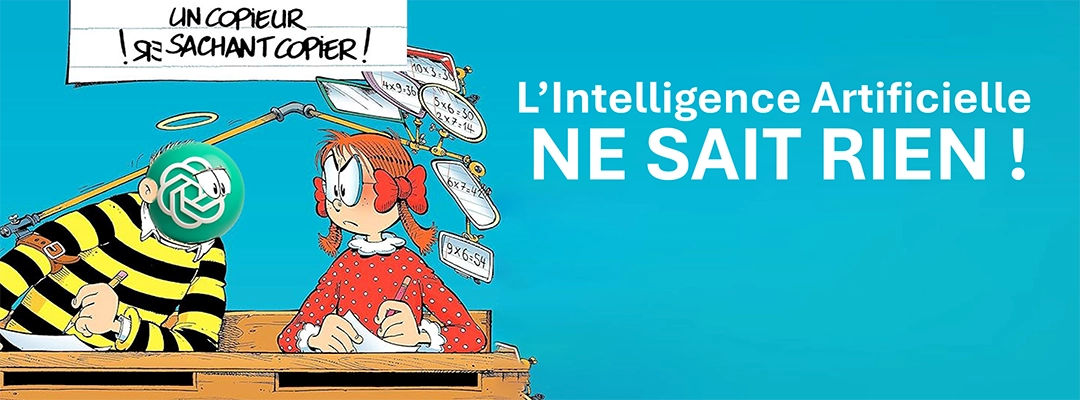

Dans un monde où l’Intelligence Artificielle devient un sujet récurrent en entreprise comme dans la presse, trop nombreux sont ceux qui fantasment encore le fonctionnement réel de l’IA et de ChatGPT. En tant que consultant, j’ai constaté à quel point cette machine prédictive est mal comprise : non, elle n’a pas emmagasiné le savoir universel, non elle ne consulte pas une immense bibliothèque en ligne à chaque réponse. Elle ne sait pas, elle devine. A chaque question elle invente sa réponse. C’est pourquoi il est vital de dépasser les idées reçues. Entre faux experts, discours marketing et effets d’annonce, je vous propose ici un éclairage rigoureux et documenté. Comprendre, c’est éviter les choix stratégiques trompeurs.

Dans l’imaginaire collectif, nourri par des articles approximatifs, ChatGPT serait une mémoire numérique capable de retrouver instantanément des milliards de données. Pourtant, cette idée est fausse. En réalité, ChatGPT ne lit ni sa base d’entraînement ni un disque dur rempli de savoirs encyclopédiques lorsqu’il répond. Et ChatGPT ne mémorise pas et n’apprend pas de vos conversations.L’Intelligence Artificielle génère simplement des réponses grâce à des modèles statistiques prédictifs. L’IA n’est pas constitué de neurones artificiels, et l’IA ne raisonne pas. Une étude du MIT (2023) précise qu’il ne consulte ni Google ni Wikipédia en temps réel. Cette croyance largement répandue chez les dirigeants nourrit une confiance aveugle envers une technologie qui, aussi brillante soit‑elle, peut induire en erreur. Penser que l’IA « sait » comme un humain est dangereux : elle ne fait qu’estimer des idées probables, jamais garantir des vérités, ce qui peut créer de graves confusions stratégiques. Cette contre-vérité est une des nombreuses en circulation sur le web, que nous démystifions dans cette rubrique « le vrai et le faux de l’IA ».

ChatGPT, tout comme Gemini ou Mistral, ne « lit » jamais sa base de données au moment de répondre. Il a été entraîné sur d’immenses volumes de textes (livres, forums, articles) afin d’apprendre à prédire les mots ou idées les plus cohérents dans une phrase. Mais pendant l’échange, il n’accède pas à ces textes : ils ont été transformés en poids et modèles mathématiques. Contrairement à un moteur de recherche, l’Intelligence Artificielle ne se souvient pas : elle estime, prédit, extrapole. C’est comme un enfant qui a appris des millions d’exemples, sans se rappeler précisément où. Selon OpenAI, la base d’entraînement n’est jamais relue à la volée. Ainsi, ses réponses peuvent être brillantes… mais aussi approximatives, et une erreur peut avoir de graves conséquences stratégiques ou financières.

Une croyance très répandue affirme qu’en demandant à ChatGPT de faire une recherche en ligne, sa réponse deviendrait forcément plus fiable. En réalité, c’est faux. Même connecté au web via des versions avancées comme ChatGPT‑4o, l’intelligence artificielle ne garantit ni fraîcheur ni exactitude : elle lit seulement ce qui lui paraît pertinent, sans vérifier la validité des sources. Lors d’un test sur la liste des femmes ayant été Premiers ministres en France, ChatGPT n’a cité qu’Édith Cresson, oubliant Élisabeth Borne. Il s’est appuyé sur un site non mis à jour depuis 2020 (comme la liste) ou sur un site difficile à analyser comme calagenda. ChatGPT ne sait pas ce qu’il ignore : il devine. D’où l’importance, pour les professionnels, de cadrer strictement l’IA pour éviter des décisions biaisées.

Ce phénomène de désinformation sur le fonctionnement réel de l’intelligence artificielle résulte d’un mélange d’ignorance et d’intérêts. Journalistes, consultants autoproclamés ou formateurs peu légitimes répètent que ChatGPT aurait « lu tout le web » et « peut répondre à tout ». C’est faux et dangereux. Cette croyance simpliste vient souvent d’une mauvaise interprétation des messages d’OpenAI et d’une vision séduisante d’une machine omnisciente. Pourtant, comme je le rappelle en conseil, l’intelligence artificielle générative ne « comprend » ni ne « raisonne » comme un humain : elle prédit des mots. Croire à cette idée mène à des contenus erronés, des documents approximatifs et des décisions stratégiques biaisées. Les dirigeants doivent intégrer cette réalité pour éviter une dépendance illusoire à un outil aussi puissant qu’imparfait.

Ce sont surtout des profils très visibles dans les médias ou sur LinkedIn qui diffusent cette idée fausse : influenceurs IA, journalistes en quête de buzz, consultants autodidactes. Ils véhiculent une image simplifiée et quasi magique de l’intelligence artificielle. Même certains dossiers ministériels entretiennent la confusion en affirmant que ChatGPT « s’informe » sur tout Wikipedia et « maîtrise » l’ensemble des textes publics. En réalité, l’IA générative ne fonctionne pas par recherche documentaire mais par simulation linguistique. Comme le disait Jacques Brel : « La bêtise, c’est de la paresse. » Répéter des idées reçues est plus simple que d’expliquer la complexité réelle des grands modèles de langage. Cette superficialité flatte l’audience mais peut mener à des erreurs stratégiques coûteuses pour les entreprises.

L’origine de cette fake news tient à un malentendu : la confusion entre la phase d’apprentissage et celle de génération. Beaucoup de commentateurs se sont trompés en lisant les publications techniques de Google DeepMind, OpenAI ou Meta. Ils ont compris que si l’IA avait été entraînée sur des textes, alors elle pouvait les retrouver. C’est faux. À cela s’ajoute la mauvaise traduction de termes mathématiques ou informatiques complexes comme transformer, weights, ou attention masking. Résultat : des affirmations erronées surgissent dans les vidéos YouTube, conférences d’entreprise ou rapports d’analystes. Autre facteur majeur : la méconnaissance du fonctionnement d’autres IA comme Mistral ou Gemini, qui agissent exactement selon les mêmes principes que ChatGPT. Toutes ne consultent pas leurs bases d’entraînement en temps réel.

L’intelligence artificielle reste prisonnière d’un mythe : celui d’un cerveau électronique capable de « penser » comme un humain. En réalité, l’IA générative, comme ChatGPT, est un modèle statistique prédisant les mots les plus probables après une phrase. Elle ne comprend pas, n’interprète pas et ne raisonne pas : elle calcule. Pourtant, beaucoup d’équipes croient encore que l’IA « sait » parce qu’elle a « lu » Wikipédia. C’est faux : c’est un outil d’estimation linguistique, pas un moteur de vérité. Employer le mot « intelligence » entretient cette illusion. Pour éviter des erreurs stratégiques, les professionnels doivent comprendre la véritable nature de l’intelligence artificielle.

Non, c’est l’une des erreurs les plus répandues sur l’intelligence artificielle : ChatGPT ne « mémorise » rien comme un humain. Son entraînement a utilisé d’immenses volumes de textes ensuite compressés et transformés en modèles mathématiques. Ainsi, quand une question est posée, l’IA n’accède ni à Internet ni à ses données d’origine. Elle évalue simplement ce qui est probable, sans se souvenir d’où cela vient. C’est comme apprendre à parler en imitant des phrases qu’on ne sait plus situer. Penser le contraire, c’est voir l’IA comme une base de données parfaite. Une réponse générée n’est jamais garantie : l’intelligence artificielle repose sur une prédiction, pas sur une recherche.

Une confusion fréquente chez les dirigeants est de croire que l’intelligence artificielle possède une compréhension humaine. C’est faux ! Cette idée conduit à trois erreurs majeures : penser que l’IA donne toujours la « bonne » réponse, lui confier des documents légaux sans contrôle, ou baser des décisions stratégiques sur ses résultats. Comme consultant, j’ai vu des erreurs coûteuses causées par un simple prompt mal rédigé ou mal interprété. En réalité, l’intelligence artificielle et l’automatisation exigent un cadre précis et une vigilance constante. Il faut maîtriser le prompt engineering et comprendre comment l’IA génère ses réponses. Seule une approche lucide permet d’exploiter la puissance de l’IA sans tomber dans l’illusion de son infaillibilité.

C’est un fantasme séduisant mais dangereux : ChatGPT ne remplace pas une vraie recherche humaine, même avec accès au web. Certaines versions peuvent analyser des pages en ligne, mais l’IA ne garantit ni l’exactitude, ni la fraîcheur, ni l’exhaustivité des informations. Lors d’un test sur une mise à jour politique, ChatGPT n’a même pas mentionné la Première ministre en poste, s’appuyant sur des sources obsolètes. J’avertis souvent mes clients : utiliser l’IA pour vérifier des documents, c’est marcher sur une corde raide. Pour une stratégie fiable, il faut toujours croiser et valider les données. Les promesses marketing ne doivent pas masquer la réalité : l’intelligence artificielle repose sur une simulation prédictive, et non sur une recherche documentaire précise.

L’image de l’IA toute‑puissante circule largement dans les milieux professionnels parce qu’elle séduit. Elle capte l’attention, crédibilise une formation ou donne l’illusion d’être en avance. C’est pourquoi certaines formations intelligence artificielle continuent de diffuser des inexactitudes sur ChatGPT, affirmant qu’il « comprend tout Internet ». Ce constat m’inquiète : la désinformation se propage sans vérification, relayée par des influenceurs LinkedIn, des consultants médias ou même des institutions publiques. Répéter des idées fausses est plus simple que d’expliquer la réalité. Pourtant, l’intelligence artificielle n’est pas une entité omnisciente. Si les professionnels bâtissent leur stratégie sur des croyances aussi erronées, les conséquences peuvent être graves. Il faut former à la réalité, et non à un mirage technologique.