Dans un climat saturé de désinformation autour de l’intelligence artificielle, j’ai choisi de déconstruire les mythes qui entourent ChatGPT, Gemini et leurs semblables dans cette rubrique dédiée aux contre-vérités sur l’IA. Pourquoi tant d’experts autoproclamés disent que l’IA raisonne ? Certains vous diront même que l’IA respire ! La réponse tient en 4 mots : l’ignorance. L’ignorance de ce que l’expression « neurones artificelles » ou « réseau de neurones » est un abus de langage utilisé depuis les années 50 pour lever des fonds. L’ignorance du prompt engineering, ce levier crucial souvent ignoré qui détermine toute la logique du modèle. Des tests révélateurs comme le simple comptage d’une même lettre dans une phrase montre l’absence de raisonnement réel. Or, avec plus de 6 600 recherches mensuelles sur “Google Gemini AI”, la demande d’explication fiable est colossale. C’est pourquoi j’ai bâti cette analyse rigoureuse et sans concession.

Je constate depuis plusieurs mois une prolifération d’affirmations trompeuses autour des IA génératives comme ChatGPT, Gemini ou Mistral. Plus l’enthousiasme grandit, plus la désinformation enfle. Les titres tapageurs affirmant que Gemini 2.5 « pense » ou que ChatGPT 4o « raisonne » faussent la perception des dirigeants. Par exemple, la majorité pense que l’IA a emmagasiné tout le savoir contenu dans les encyclopédies, alors que l’IA n’a juste pas de mémoire persistante ! Certains vont même vous dire qu’il faut lui donner le temps de respirer pour qu’elle raisonne encore mieux. Derrière ces messages se cachent souvent des intérêts marketing, renforcés par un manque de formation du public. C’est sans excuse car certains site, comme la rubrique formation gratuite à l’IA sur celui-ci, donnent accès à la véritable information, et l’abonnement gratuit au site IA fournit de nombreux contenus et outils pour se former facilement.

Certains acteurs exploitent la confusion régnante sur le sujet pour diffuser des idées biaisées, comme l’ont montré nos tests récents. Il est donc vital d’adopter un esprit critique et de s’appuyer sur des sources techniques fiables. Rien que la requête “Google Gemini AI” génère déjà 6 600 recherches mensuelles.

Les fausses promesses autour de l’IA obéissent souvent à des logiques économiques. Certains soi-disant experts jouent sur la peur ou l’euphorie pour générer des clics ou vendre des services. J’observe notamment de plus en plus de contenus utilisant des termes comme « thinking model » ou « IA consciente », des oxymores séduisants mais trompeurs. Stratégie fréquente : lever des fonds, nourrir le FOMO ou convaincre des investisseurs peu avertis. Une étude récente de la MIT Sloan School of Management montre que les annonces exagérées autour de l’IA gonflent artificiellement la valorisation des startups de 28 % en moyenne. Les enjeux sont majeurs. Ici, le prompt engineering s’impose pour rétablir des bases solides.

Je remarque que ces fausses informations viennent essentiellement de trois sources : les influenceurs LinkedIn sans compétences techniques, les petits organismes de formation improvisés et certains consultants dont la seule légitimité repose sur la répétition de prompts de 3 à 10 lignes sur ChatGPT, Gemini etc. Ces pseudo-experts partagent des contenus spectaculaires mais souvent creux, et leurs affirmations sont rarement sourcées. L’emploi excessif de phrases telles que « l’IA pense que » trahit leur ignorance sur le comportement réel d’un modèle de langage. Ces propos renforcent la confusion chez les décideurs, alors même que comprendre les véritables limites des IA est capital.

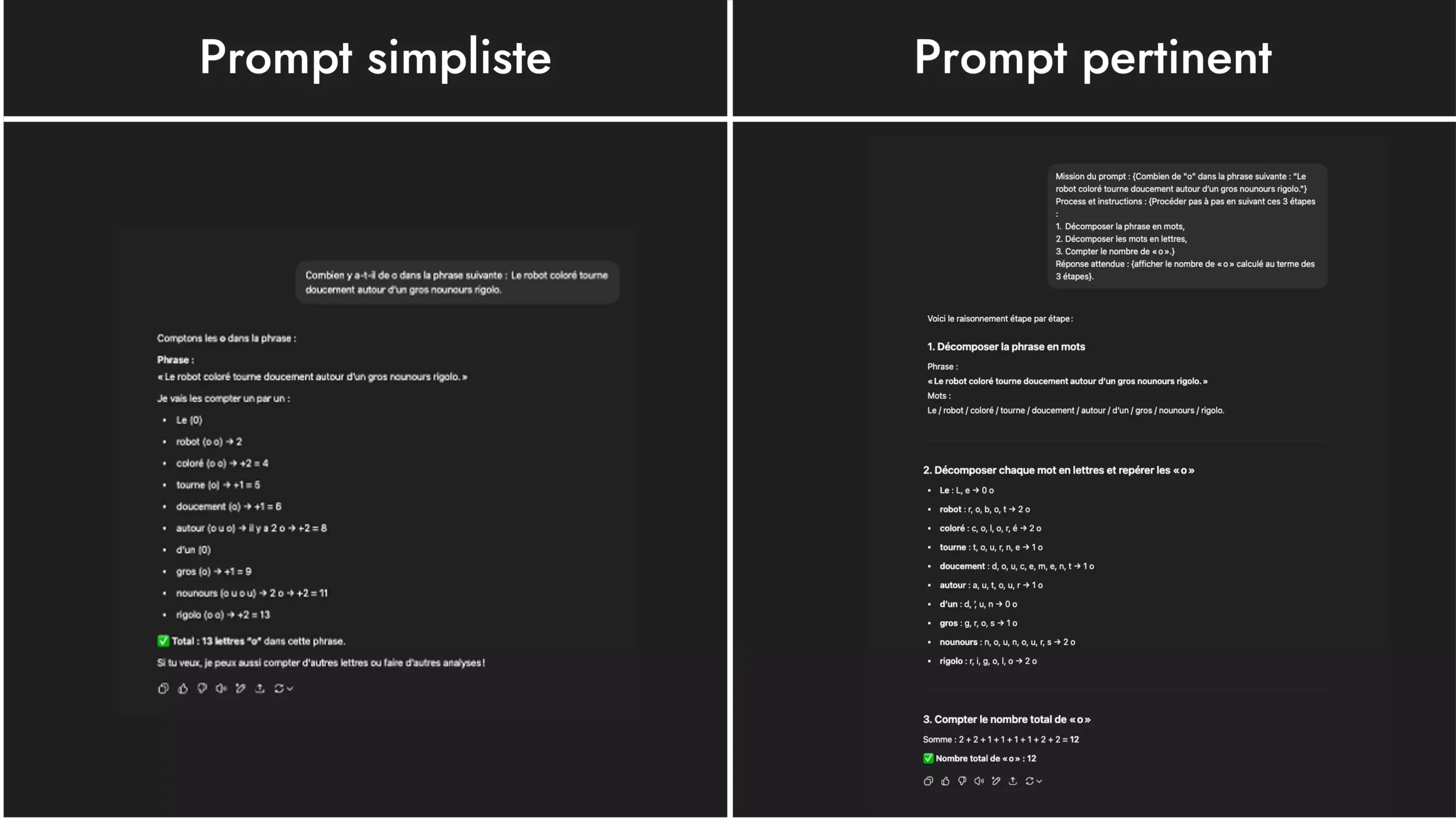

Il est temps de démonter clairement l’idée selon laquelle ChatGPT ou Gemini posséderaient une véritable capacité de réflexion humaine. Beaucoup se laissent encore tromper par des démonstrations spectaculaires, croyant à tort que ces modèles « pensent » réellement. Pourtant, derrière l’illusion se cachent uniquement des calculs de probabilités et des corrélations statistiques. Pour s’en convaincre, il suffit d’un test de comptage très simple. Cet exemple volontairement élémentaire révèle, avec une précision désarmante, les limites surprenantes de ces IA prétendument intelligentes.

Prenons la phrase suivante :

« Le robot coloré tourne doucement autour d’un gros nounours rigolo. »

Combien de lettres « o » contient‑elle exactement ? La bonne réponse est 12. Pourtant, lorsque l’on soumet cette phrase à différents modèles, même parmi les plus récents comme ChatGPT 4o, on obtient des réponses étonnamment variées, allant de 11 à 17. Ce décalage révèle une faiblesse majeure : sans consignes précises et détaillées, l’IA échoue sur des tâches simples que tout humain réalise naturellement et sans effort.

Refaites le test dans un nouveau chat en utilisant un prompt détaillé :

Mission du prompt : {Combien de « o » dans la phrase suivante : « Le robot coloré tourne doucement autour d’un gros nounours rigolo. »}

Process et instructions : {Procéder pas à pas en suivant ces 3 étapes :

Réponse attendue : {afficher le nombre de « o » calculé au terme des 3 étapes}.

Cette fois, le résultat est exact. Ces tests prouvent que la réussite dépend avant tout de la qualité du prompt, non d’une intelligence réelle. Même Gemini 2.5 échoue sans guidage précis, confirmant que le prompt engineering reste le véritable cœur des IA.

C’est un fait incontournable : les IA les plus performantes n’obtiennent pas de bons résultats seules. Elles s’appuient systématiquement sur deux cycles d’entraînement : l’apprentissage supervisé (SSL) et les boucles de renforcement humain (RLHF). Lorsqu’on combine ces méthodes avec un prompt logique bien construit, on obtient des résultats corrects, mais cela reste une mécanique sans conscience. C’est pourquoi je recommande vivement aux décideurs de former leurs équipes au prompt engineering pour ne pas supposer une intelligence là où il n’y a que du traitement statistique. En l’absence d’un encadrement méthodique, les IA – même les plus avancées – produisent des erreurs fréquentes.

Les réponses exactes viennent rarement du modèle seul, qu’il s’agisse de ChatGPT ou de Gemini. Elles résultent de deux facteurs :

1) la pertinence des instructions données en entrée via le prompt ;

2) le système de correction par renforcement humain. Cette approche, appelée RLHF – Reinforcement Learning by Human Feedback, permet aux modèles d’apprendre des rétroactions pendant leur phase de calibration (source : OpenAI Technical Report, avril 2023). Il s’agit d’un affinage progressif, pas d’un véritable raisonnement. Sans ces ajustements, même un GPT‑4o ou Gemini peut produire des résultats incohérents. Voilà pourquoi je m’astreins toujours à concevoir avec précision mes prompts, même pour des tâches élémentaires.

Oui, c’est bien cet encodage dans le prompt de sept principes logiques – Lecture attentive, Compréhension, Planification, Organisation, Rigueur, Validation et Synthèse – qui fait la différence. Nous faisons plus de 1000 de tests sur ChatGPT-4o, Gemini, Mistral etc. par an : quand ces principes sont appliqués dès le prompt, la qualité de la réponse est démultipliée. Le résultat : moins d’ambiguïtés, plus de cohérence. Ces principes n’émanent pas d’une réflexion du modèle, mais d’un cadre algorithmique structurant son comportement. C’est en cela que le prompt engineering est plus qu’un art : c’est une discipline rationnelle basée sur des règles exploitables.

Les conséquences de cette désinformation sont colossaux. J’ai vu plusieurs dirigeants suspendre leurs projets IA en attendant… une génération de modèles supposés « pensants ». Cette attente stérile engendre une perte d’agilité dans un marché qui, lui, ne ralentit pas. On se prive ainsi des bénéfices concrets que les IA actuelles peuvent offrir avec une bonne formation. De même, les erreurs issues d’une mauvaise compréhension renforcent le rejet de l’IA ou l’inefficacité de son usage. Il est donc vital de déconstruire ces fausses croyances, et cela commence, selon moi, par une initiation rigoureuse au prompt engineering.

Je suis frappé de constater du nombre de dirigeant qui à l’image de l’exemple précédent suspendent leurs investissements IA dans l’attente d’une soi-disant « super-IA » pensante et autonome. Or, les données actuelles montrent que nous en sommes très loin. Selon Sam Altman, CEO d’OpenAI, « without a new architecture, real artificial general intelligence (AGI) is still 10 years away at least » (source : Interview NYT, mai 2024). Attendre revient donc à stagner. Pendant ce temps, les entreprises concurrentes automatisent déjà leurs contenus, leur service client ou leur prospection, grâce à une IA bien dirigée. Voilà pourquoi il est dangereux de confondre les fausses informations du web et stratégie réelle.

Absolument. Le manque de formation est, selon moi, un facteur aggravant majeur. Trop d’équipes pensent que ChatGPT ou même Gemini s’utilisent comme Google : en posant des requêtes vagues. Le résultat ? Des réponses incomplètes, floues ou carrément fausses. Un rapport de McKinsey paru en décembre 2024 montre que 72 % des erreurs d’interprétation des LLM, y compris sur Gemini, proviennent d’une mauvaise construction des prompts (source : McKinsey Digital Report, 2024). Former les collaborateurs à rédiger des instructions précises, neutres et complètes améliore la performance globale et permet d’exploiter sainement tout le potentiel de l’IA et de Gemini.

Il ne suffit pas de critiquer les fausses idées. Il faut, selon moi, proposer une alternative claire : initier les professionnels au prompt engineering. La solution repose sur une formation rigoureuse, actualisée et opérationnelle. L’approche DOMPTER, que CBS a mise en place, vise justement cela : outiller les utilisateurs pour qu’ils pilotent ChatGPT et ses concurrents, plutôt que de subir les illusions marketing. C’est en maîtrisant les relations entre prompt, IA et objectif business qu’on transforme réellement l’IA en levier stratégique. Loin des promesses irréalistes, cette méthode aligne logique humaine et comportement algorithmique.

La méthode DOMPTER propose une structure en 7 étapes. Nous l’avons conçue après avoir constaté que la plupart des formations recommandent de « parler poliment » à ChatGPT, en le tutoyant et avec des prompts très courts. Or, ce n’est pas ce que le modèle attend. Il nécessite une structure logique claire, adaptée à sa façon de traiter les données. Selon nos tests et la mise en place de cette stratégie auprès de nos clients, ceux qui l’ont appliquée ont réduit de 43 % le temps de création de contenus IA dès les deux premières semaines.

Notre programme dépasse largement les standards actuels : +700 prompts classés, 3 modules sur l’automatisation, un chapitre entier dédié au SEO + IA, et une application intégrée PhotoPrompt pour créer des visuels générés par IA. De plus, les mises à jour sont garanties avec chaque nouvelle version majeure de ChatGPT (ChatGPT-5 en approche été 2025). Ce sérieux pédagogique est ce qui l’aligne le mieux avec les besoins concrets des professionnels. Attention, il ne s’agit pas de télécharger un PDF rempli de prompts passe-partout mais bien d’un apprentissage graduel et structuré, basé sur des heures d’expérimentation.

Je crois qu’au centre de cette effervescence autour de l’intelligence artificielle, une clarification essentielle s’impose : les IA comme Gemini ne « pensent » pas, elles corrèlent. C’est pourquoi le rôle méconnu mais fondamental du prompt engineering mérite d’être mieux compris : il aiguillonne les modèles, oriente leurs résultats, sans créer de réflexion autonome. En décryptant les fonctionnalités de Gemini 2.5 et ses limites, je voulais redonner la juste place à ces outils puissants mais impersonnels. En conséquence de quoi, la lucidité reste notre meilleure alliée dans ce débat trop souvent biaisé par des buzzwords comme Gemini AI thinking model.

Non, et il est crucial de le dire sans détour : Google Gemini AI ne possède aucune forme de réflexion autonome. Ce modèle – tout comme ChatGPT – fonctionne principalement par corrélation statistique et non par raisonnement. Il n’“interprète” pas, il réagit à un prompt, en puisant dans son immense base de données de mots. C’est là que le prompt engineering prend toute sa valeur : il agit comme une télécommande algorithmique qui guide (ou non) la justesse des résultats. Ce que beaucoup prennent pour une forme d’ « intelligence » n’est en réalité qu’une illusion nourrie par des patterns et non par une pensée consciente.

Parce que dans un monde digital saturé par le buzz, les promesses spectaculaires attirent l’attention et soutiennent des intérêts économiques. Des influenceurs sans connaissance technique réelle véhiculent l’idée que Gemini 2.5 « raisonne seul », histoire d’amplifier la hype. En vérité, ces modèles reposent sur des architectures probabilistes, gouvernées par le prompt engineering plus que par une quelconque logique humaine. Je le dis souvent : il ne suffit pas de parler à une IA pour qu’elle comprenne – il faut la piloter, maîtriser les séquences et intégrer les 7 principes logiques que je recommande dans mes formations.

Je mène souvent un test basique mais redoutable : demander à une IA de compter les occurrences d’une lettre dans une phrase. Par exemple : combien de « o » dans « To be or not to be that is the question » ? Résultat ? La plupart échouent. Pourquoi ? Parce que ces modèles ne comprennent pas. Ils prédisent la prochaine séquence de mots, sans examen logique réel. Sauf si le prompt engineering encode minutieusement chaque étape : lecture, planification, vérification. C’est ainsi que l’on transforme une simple prédiction en un semblant de raisonnement… mais soyons lucides, ce n’en est toujours pas un.

C’est très rare. Même les IA comme ChatGPT-4o ou Gemini 2.5 Flash Thinking atteignent des résultats pertinents uniquement si le prompt est clair, structuré, et enrichi de logique. Sans cela, elles font des erreurs. Les phases d’entraînement, comme le RLHF (Reinforcement Learning by Human Feedback), aident… mais ne remplacent jamais l’intervention humaine stratégique. Et croyez-moi, j’ai testé tous les niveaux de requêtes. Ce que l’on perçoit comme de la performance provient avant tout d’une orchestration millimétrée par le prompt engineering. Un prompt négligé = un résultat inexploitable. Ce n’est pas un raccourci, c’est une réalité.

Parce que croire que ces modèles sont auto-intelligents conduit les entreprises à des échecs coûteux. J’ai vu des directions métiers perdre des semaines à attendre « la prochaine génération d’IAs pensantes »… alors que la clé était entre leurs mains : structurer leur façon de poser leurs requêtes. Selon McKinsey, 72 % des erreurs chez les LLM viennent de mauvais prompts. J’en suis témoin au quotidien. En formant ses équipes au prompt engineering, avec des méthodes rigoureuses comme DOMPTER, on libère enfin tout le potentiel de Gemini AI. C’est bien plus que savoir « parler à une IA », c’est apprendre à la commander.