ChatGPT, avec ses réponses bluffantes et sa fluidité, fascine autant qu’il intrigue. Pourtant, une idée fausse persiste : celle selon laquelle il apprend constamment de ses utilisateurs. C’est une contre-vérité parmi d’autres, telles que l »IA raisonne, l’IA respire, il faut attribuer un rôle à l’IA etc. Dans cet article détaillé, je démonte cette croyance infondée en m’appuyant sur des tests concrets en prompt engineering, afin de distinguer le fantasme technologique de la réalité technique. C’est pourquoi comprendre ce que fait véritablement un LLM devient crucial pour une utilisation sensée, lucide et efficace de l’IA.

ChatGPT, omniprésent dans les discussions numériques, reste victime d’une idée reçue : « ChatGPT apprend de chaque interaction ». C’est faux. C’est un mythe qui ressemble au mythe de la mémoire persistante de ChatGPT. Comme tout modèle de langage, il n’évolue pas à chaque conversation : son corpus de données reste figé après l’entraînement initial. Même des experts peu avertis tombent dans ce piège. ChatGPT n’est pas une mémoire adaptative interagissant en temps réel, mais plutôt un immense dictionnaire contextuel. L’IA générative ne devient pas plus intelligente au fil de vos échanges : elle ne collecte ni ne modifie vos données, elle prédit simplement la meilleure réponse selon sa base figée. Les évolutions se font uniquement lors de nouvelles versions via des corrections humaines (RLHF) appliquées périodiquement.

En tant que professionnel de l’intelligence artificielle, je croise encore trop souvent cet argument erroné : ChatGPT serait un logiciel d’apprentissage continu en ligne. Or, sur le plan technique, c’est inexact. ChatGPT ne possède ni mémoire persistante en conversation standard, ni système d’apprentissage en « streaming » comme le font certains outils participatifs. Chaque session de dialogue est indépendante, sans impact sur les réponses futures. Cette conception figée évite les dérives types biais de confirmation ou renforcement de propos erronés.

Ce malentendu provient souvent de l’emploi abusif de termes comme « machine learning », « fine-tuning », ou « IA auto-apprenante », souvent utilisés à tort. En réalité, le modèle GPT repose sur un entraînement supervisé et des ajustements post-modèles appelés RLHF, qui ne se font jamais en direct.

J’ai personnellement mené des dizaines de tests avec mes clients professionnels, et les résultats sont sans appel. ChatGPT répète des erreurs, même après les lui avoir signalées — preuve irréfutable de son absence d’apprentissage interactif. Prenons un exemple emblématique :

Cela illustre deux failles majeures : (1) l’incomplétude de l’entrainement qui se limite à des calculs de probabilités, (2) la non-récursivité des réponses données. Ces limites ont des impacts concrets : mauvais choix stratégiques, publications contenant de fausses informations, manque de rigueur dans les contenus SEO. Ce danger est accentué par la prolifération de formations sur le « prompt engineering » fournissant des prompts simplistes et erronés — ce qui explique aussi la faiblesse de certaines stratégies de référencement associant Chatgpt et SEO.

La diffusion de cette idée fausse vient d’une confusion technique et d’un manque de pédagogie de la part de nombreux prétendus « spécialistes IA ». En parcourant commentaires et formations en ligne, on constate qu’au lieu d’expliquer clairement les étapes d’apprentissage d’un LLM, beaucoup préfèrent vendre du rêve technologique, quitte à désinformer. Les termes « apprentissage », « intelligence » ou « fine-tuning » sont souvent employés sans nuance, renforçant la croyance qu’un outil comme ChatGPT apprend de chaque utilisateur. Cette confusion s’appuie aussi sur une volonté de se présenter en pionnier : dire que ChatGPT apprend en direct donne l’illusion d’un outil magique et malléable. Mais cette capacité n’existe pas. Cette croyance nourrit alors des attentes irréalistes, une surconfiance dans les réponses fournies et la généralisation de méthodes non validées dans le prompt engineering.

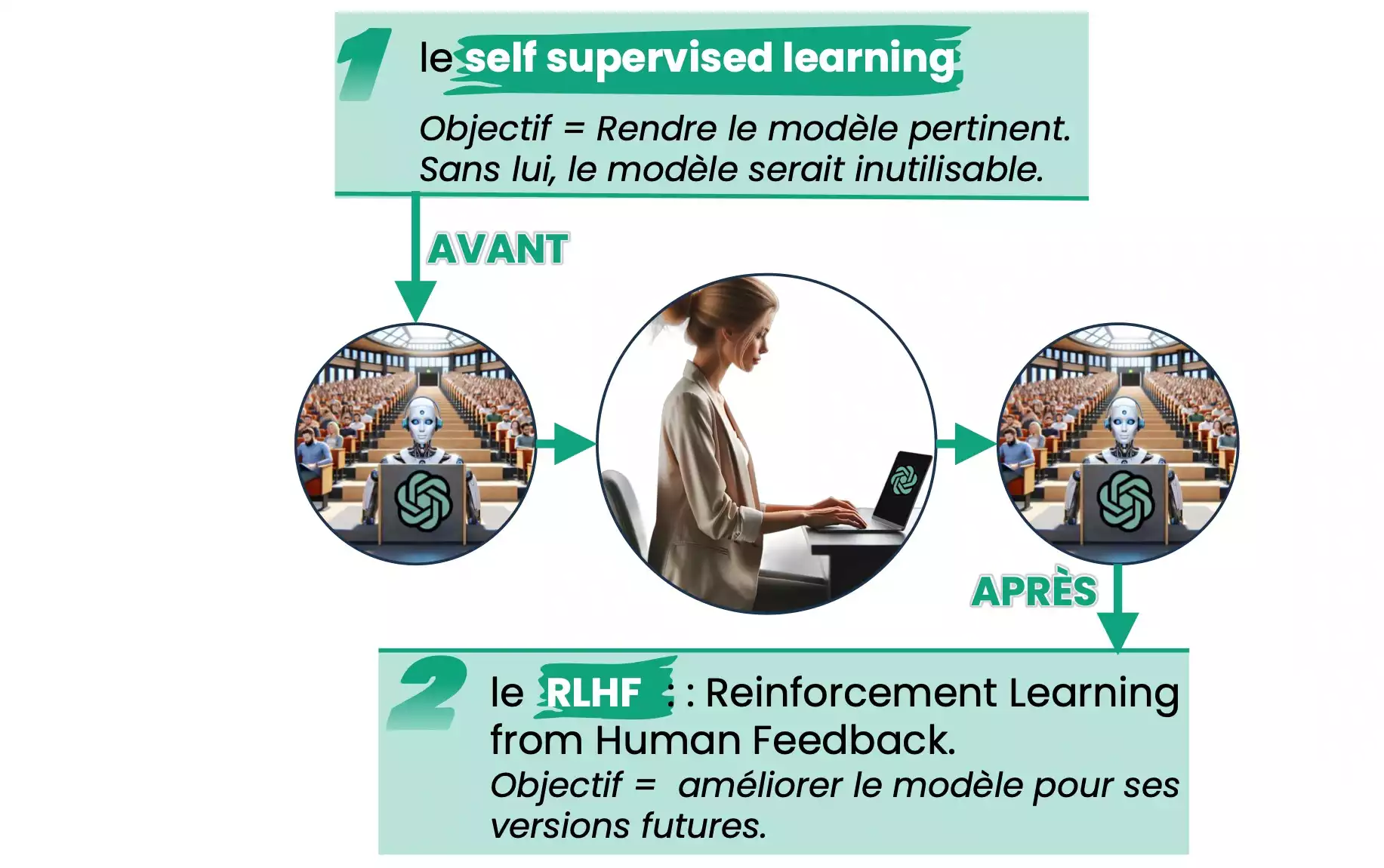

Il est essentiel de distinguer deux étapes clés dans l’apprentissage d’un modèle comme ChatGPT : le « Self-Supervised Learning » (SSL) et le « Reinforcement Learning with Human Feedback » (RLHF). Le SSL consiste à entraîner l’IA sur d’immenses volumes de textes (570 Go pour GPT‑3) afin qu’elle apprenne à enchaîner les mots de façon pertinente. Le RLHF intervient ensuite, des mois plus tard : des évaluateurs humains notent et classent les réponses pour affiner le modèle.

Aucun de ces processus ne se déroule en temps réel. Pourtant, beaucoup confondent encore ces étapes avec un apprentissage « live ». D’où la croyance infondée que ChatGPT s’adapte comme un CRM ou un moteur de recommandation. En réalité, sauf fine‑tuning très spécifique en back‑office, ChatGPT ne retient rien. D’où la nécessité d’une approche rigoureuse et structurée du prompt engineering.

La désinformation est hélas souvent orchestrée par des formateurs improvisés, des influenceurs ou des consultants non qualifiés. En analysant le contenu de certaines formations, on y découvre des prompts de trois lignes, tutoyant ChatGPT et attribuant des rôles fantaisistes à l’IA, sans rigueur méthodologique. Ce manque de compréhension diffuse des pratiques contre-productives, voire dangereuses pour les stratégies des entreprises.

Ces pseudo-experts s’appuient souvent sur des tutoriels copiés de ressources anglophones sans les adapter ni les comprendre réellement. Conséquence ? Une formation intelligence artificielle orientée vers la facilité et l’illusion de contrôle. Résultat pratique mesuré : contenus marketing erronés, décisions stratégiques basées sur de fausses promesses, et pénalités SEO pour contenu dupliqué ou mal ciblé.

Penser que ChatGPT apprend activement des utilisateurs entraîne des conséquences sérieuses. Cette croyance nourrit des attentes irréalistes chez dirigeants et responsables, convaincus qu’en multipliant les prompts l’outil s’améliorera seul. Ce fantasme d’une IA « magique » crée une dangereuse surconfiance : dans plusieurs entreprises, j’ai vu des équipes cesser de vérifier les réponses, persuadées que ChatGPT devenait plus « intelligent ». C’est totalement faux.

Cette illusion est entretenue par des formations superficielles qui ignorent les limites techniques des LLM. Sans apprentissage rigoureux de l’automatisation ou du SEO assisté par IA, les entreprises s’exposent à des contenus mal référencés, à des erreurs juridiques ou à des biais persistants. Les prompts mal conçus ne lient ni résultats ni intention de recherche, et encore moins le référencement. Automatiser avec ChatGPT exige méthode, stratégie et vérifications constantes.

L’une des premières mauvaises habitudes consiste à rédiger des prompts incomplets ou trop généraux, en espérant que ChatGPT affine seul les prochaines réponses. Ce que je vois souvent : des équipes marketing qui répètent un prompt médiocre en boucle, pensant que l’IA en apprendra davantage au fur et à mesure. En vérité, c’est le contraire : l’outil livrera toujours des réponses proches, voire erronées, si on n’augmente pas la précision manuellement dans la rédaction du prompt.

Cela provoque mécaniquement des contenus standardisés, parfois biaisés ou incohérents, qui nuisent au positionnement. Intégré dans des systèmes de production automatisée sans vérification, cela peut ruiner la stratégie de génération de contenu. Et lorsqu’on le combine avec une automatisation non contrôlée, les effets négatifs se multiplient : baisse de la qualité, désengagement du lectorat, mauvais classement SEO.

Croire à un apprentissage dynamique conduit à une erreur majeure : ne pas intégrer de requête Web explicite dans les prompts. ChatGPT se base alors uniquement sur son savoir figé, souvent daté, ce qui impacte directement le SEO : contenus obsolètes, incomplets ou faux. Cette confusion est fréquente dans les stratégies de content marketing, où l’on pense à tort que ChatGPT suffit à produire un texte optimisé.

Un prompt efficace doit pourtant définir clairement le contexte, inclure des données récentes, des mots‑clés pertinents et idéalement des sources externes. Sans ces éléments, l’optimisation SEO reste fragile et les résultats décevants. D’après Semrush, 45 % des contenus IA sans validation humaine obtiennent des performances inférieures à ceux supervisés par des experts. La conclusion est claire : pour un contenu fiable, l’IA doit être guidée et ses réponses vérifiées.

Contrairement à une idée répandue, ChatGPT ne « découvre » rien de nouveau durant vos échanges. Il fonctionne grâce à deux phases distinctes : le « self‑supervised learning » et le RLHF. Dans la première, l’IA ingère d’immenses volumes de textes pour apprendre à prédire le mot suivant. GPT‑3, par exemple, a été entraîné sur 570 Go de données issues de Wikipédia, Reddit, Common Crawl, livres et forums. Ensuite, le RLHF intervient : des humains notent et classent les réponses afin d’affiner le modèle.

Ces étapes sont totalement déconnectées de l’usage courant. Aucun apprentissage ne se fait en direct lors de vos sessions. Une fois le modèle publié, il reste figé jusqu’à sa prochaine mise à jour, sans mémoriser vos interactions ni adapter son comportement. C’est un système fermé entre deux phases d’entraînement.

Le self-supervised learning est central car il détermine 90 % des capacités linguistiques de ChatGPT. Il s’agit pour le modèle d’apprendre à partir de vastes corpus textuels sans labélisation spécifique. Concrètement, l’IA apprend à compléter des phrases, à prédire le mot suivant, à établir des connexions syntaxiques et logiques entre les mots. Ce processus est automatisé et massif. Résultat : une grande fluidité de langage, mais une capacité limitée à lier des faits ou à comprendre des vérités.

Ce type d’apprentissage donne donc à l’intelligence artificielle une forme d’habileté grammaticale sans pour autant conférer de capacité cognitive réelle. Voilà pourquoi, malgré son apparence conversationnelle, ChatGPT ne pourra jamais répondre avec certitude à une actualité datée post-formation. Pour gagner en efficacité et pertinence, il est impératif d’intégrer dans les prompts des éléments contextuels précis, et de valider ensuite manuellement les résultats.

Le RLHF complète l’apprentissage automatique par un feedback humain. Des évaluateurs classent les réponses exportées de ChatGPT pour l’aider à prioriser celles attendues et éviter propos toxiques ou hors sujet. Mais cette méthode a des limites : annotations coûteuses et limitées, critères variables entre évaluateurs, et aucune mise à jour en temps réel.

Ainsi, les erreurs publiées persistent jusqu’à la prochaine version ; personne ne corrige les réponses au fil de l’eau. Toute stratégie IA doit donc inclure une validation humaine des contenus générés.

Maîtriser ChatGPT demande bien plus qu’un usage intuitif : c’est une compétence qui se développe par une pratique rigoureuse et un prompt engineering structuré. Une formation sérieuse à l’IA et à ChatGPT (Mistral, Grok, etc.) permet de dépasser la fascination et d’en faire un véritable allié stratégique pour automatiser et optimiser son contenu.

Non, et c’est une erreur tenace que je vois trop souvent dans les forums ou même dans certaines formations IA. Contrairement à l’idée reçue, ChatGPT ne mémorise rien d’une discussion à l’autre. Il ne dispose pas de mémoire active par défaut. Ce que l’on prend pour une évolution de l’outil est en réalité une illusion d’adaptation. Le modèle repose sur une base de données figée post-entraînement et n’évolue pas automatiquement au fil des conversations. Voilà pourquoi une véritable démarche de qualité via une chatgpt formation est indispensable : elle vous apprend à développer des prompts solides, plutôt que de compter sur un « apprentissage magique » inexistant.

Parce que sans structure ni connaissance du fonctionnement d’un LLM, on passe vite à côté du potentiel réel de l’outil. Nombreux sont ceux qui pensent qu’il suffit de « discuter » avec ChatGPT pour qu’il comprenne leur domaine. Or, sans prompt engineering, résultats répétitifs ou inutilisables assurés. Une vraie formation permet de comprendre les limites du modèle, d’identifier les biais et de rédiger des requêtes adaptées aux besoins métier. Pour automatiser la création de contenu avec ChatGPT, il faut plus que des questions aléatoires : il faut une stratégie. Et elle ne s’improvise pas. Je l’enseigne régulièrement et les résultats parlent d’eux-mêmes.

Non, ChatGPT vous répondra toujours en se basant uniquement sur les instructions du prompt en cours. Il ne se « souvient » pas de qui vous êtes. L’idée selon laquelle l’IA apprend en vous « connaissant mieux » est séduisante, mais techniquement fausse. Imaginez une photocopieuse : peu importe combien de fois vous appuyez sur un bouton, elle ne deviendra pas plus intuitive. Sans une formation ChatGPT correcte, cette confusion mène à des stratégies IA bancales et de faibles performances en automatisation ou en SEO.

Je vois régulièrement des professionnels, parfois chevronnés, élaborer des prompt de trois à dix lignes qui n’apportent aucun process permettant à l’IA de fournir la bonne réponse. Résultat ? Réponses vagues, généralités, ou pires encore : informations erronées. L’une des pires habitudes est de supposer que ChatGPT va « deviner » l’intention. Une autre est de ne pas intégrer de données à jour, pensant que l’outil ira les chercher automatiquement. Faux. Sans recherche Web activée, ChatGPT ne peut rien « apprendre ». D’où l’urgence d’une formation ChatGPT sérieuse, qui enseigne non seulement l’écriture pertinente de prompt, mais aussi l’esprit critique face aux réponses.

C’est capital. Un prompt mal conçu, sans contexte clair ou objectif de recherche précis, donne un texte fade, parfois même pénalisé par les moteurs de recherche. J’ai comparé, lors de tests terrain, des contenus générés avec et sans stratégie : différence flagrante de lisibilité, d’originalité… et donc de positionnement. Pour réussir son SEO avec Chatgpt, il est indispensable de structurer l’information autour de mots-clés pertinents, de formules engageantes et surtout de vérifications humaines. Une formation ChatGPT adaptée permet justement cela : transformer un outil puissant en allié stratégique pour le référencement naturel et la visibilité durable.