L’intelligence artificielle générative, avec des outils comme ChatGPT, s’impose désormais dans les stratégies métier les plus exigeantes. Pourtant, son utilisation reste souvent instinctive, voire maladroite, faute de méthode claire. Je le vois tous les jours : dirigeants, marketers, communicants pensent dialoguer avec une entité « qui comprend », alors qu’ils s’adressent à un calculateur de probabilités. Cet article vous plonge dans les dérives courantes, les erreurs critiques – et surtout, les clefs pour y remédier. À travers des cas concrets comme la lecture de gros fichiers avec l’IA ou les abus en prompt engineering, je dévoile comment transformer vos prompts ChatGPT et toutes IA en levier stratégique redoutablement fiable.

L’intelligence artificielle générative est devenue incontournable, mais reste mal comprise. Des millions d’utilisateurs échangent avec des chatbots comme ChatGPT en tutoyant l’IA comme s’il s’agissait d’un humain, sans réellement saisir leur fonctionnement. Cette méconnaissance entraîne des erreurs majeures, comme croire qu’on peut lui donner un gros document et attendre un résumé fidèle. Or les limites en tokens empêchent cette lecture complète : l’IA ne traite qu’une partie et ignore le reste. Sans méthode ni formation à l’IA, au moins lire un guide professionel gratuit sur l’IA, ces erreurs se multiplient. ChatGPT, Mistral ou Gemini ne « comprennent » pas, ils prédisent des mots selon des probabilités. Dépasser la limite de tokens conduit à des oublis aléatoires. Voilà pourquoi ces IA peuvent livrer des réponses fausses mais convaincantes. Comprendre le fonctionnement des IA et des LLM, et acquérir un minimum de culture IA est essentielle pour éviter ces pièges.

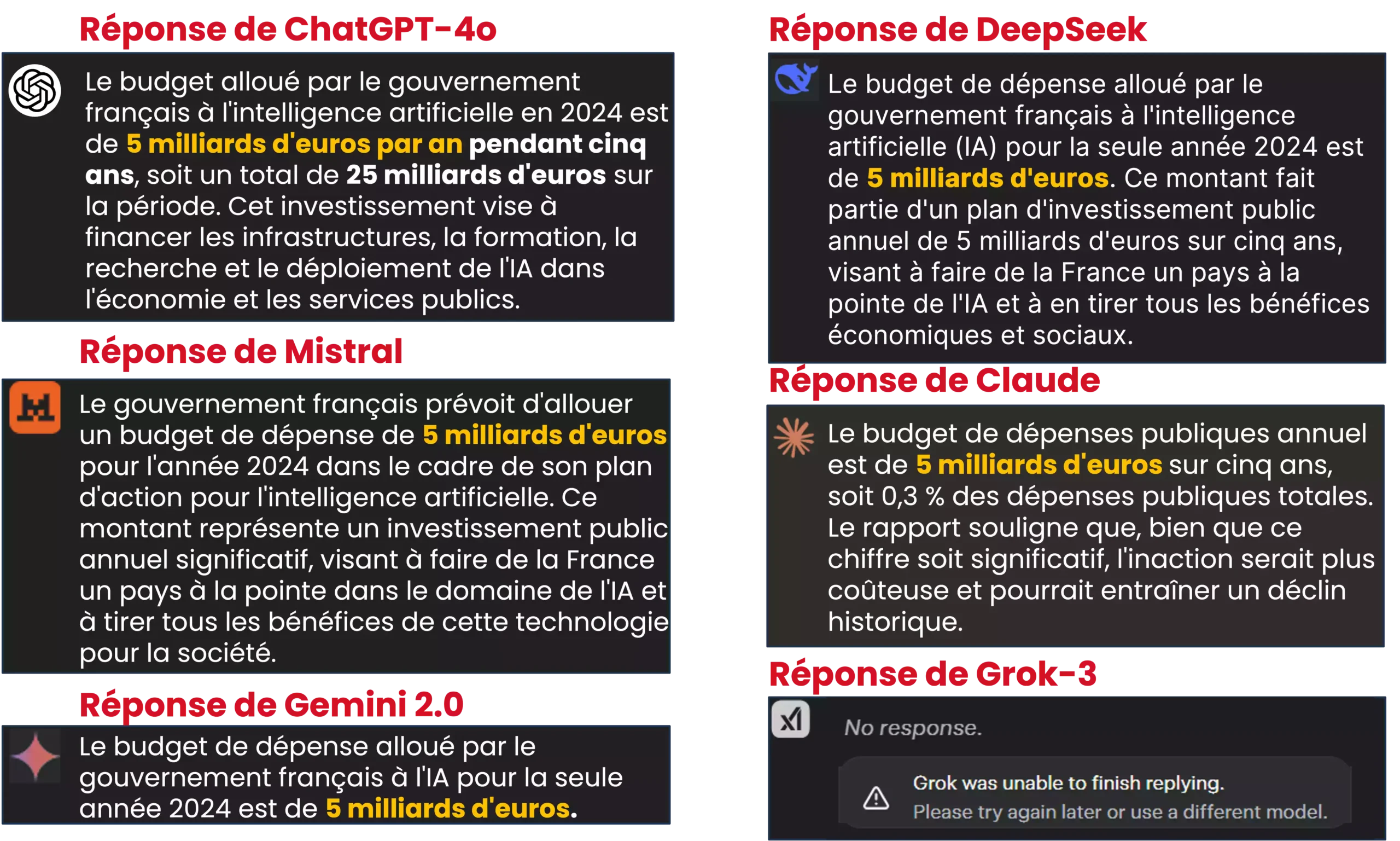

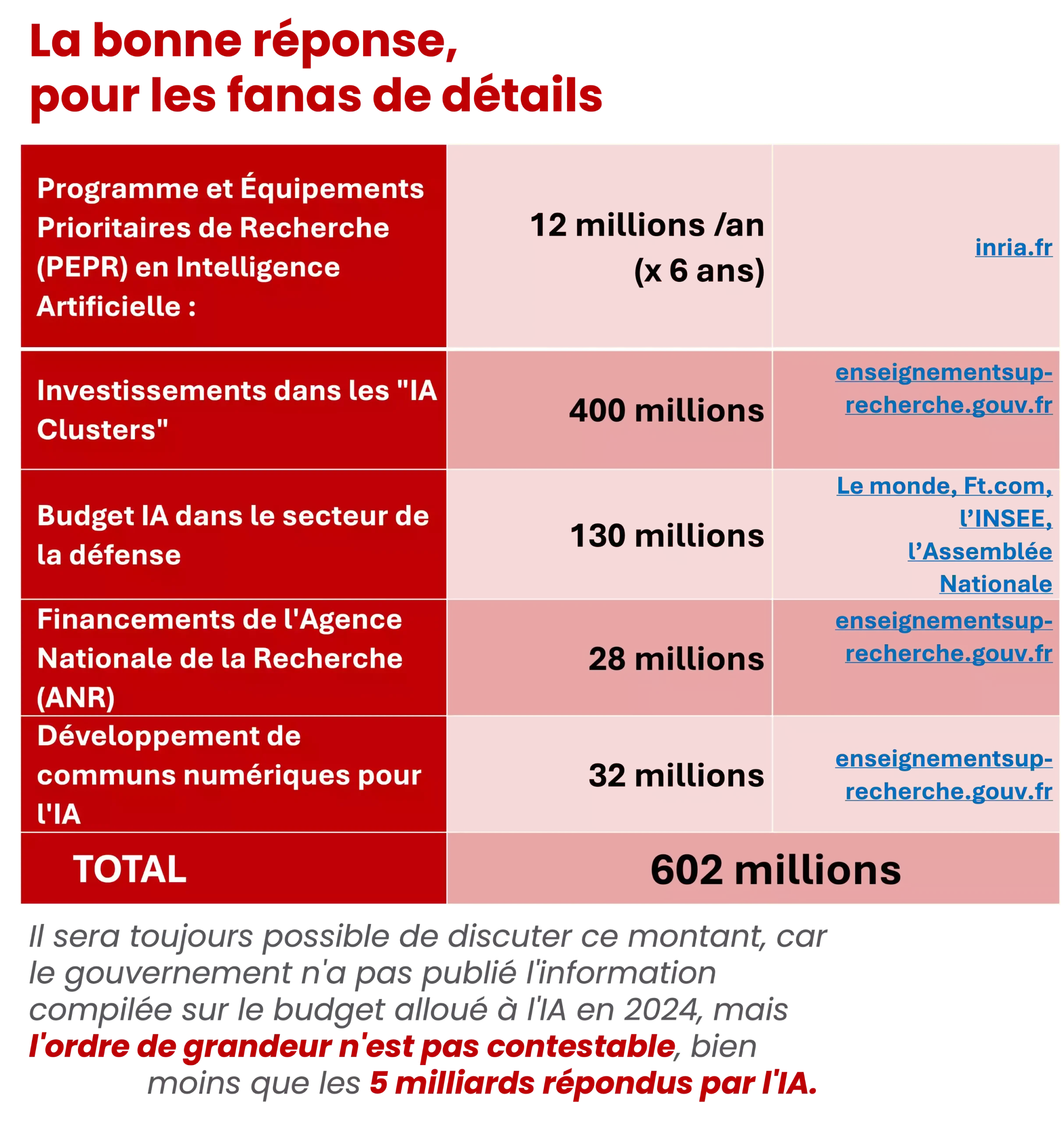

Lorsqu’on interroge ChatGPT‑4o ou Gemini sur le budget du gouvernement français pour l’IA en 2024, aucun ne donne la vraie valeur. La plupart avancent 5 milliards d’euros, parfois 3, 2,5 ou même 0,3. Pourtant, le chiffre exact est 602 millions d’euros, comme l’indiquent les lignes budgétaires officielles. D’où vient cet écart ? Aucun modèle n’a vérifié l’adoption réelle du budget. Ils extrapolent à partir de mots‑clés tels que « Budget France » ou « Intelligence artificielle », sans analyse précise du texte. Cela crée l’illusion d’une réponse fiable alors qu’il ne s’agit que de permutations lexicales. Ces erreurs, souvent invisibles, peuvent pourtant orienter de mauvaises décisions, en particulier dans un contexte B2B où la précision est critique.

Je ne le répèterai jamais assez : une IA comme ChatGPT ne raisonne pas, elle calcule selon des lois statistiques. Elle ne comprend ni les nuances ni les incohérences. Ce fonctionnement probabiliste est la source de nombreuses erreurs. Par exemple, si vous demandez : « Donne-moi le budget IA de la France pour 2024 », l’outil prédit mot après mot ce qui est le plus probable, pas forcément exact. ChatGPT, Mistral ou Gemini ne vérifient rien et ne possèdent aucun esprit critique. Pour obtenir une vérité fiable, il faut structurer votre requête avec des instructions strictes, sinon vous risquez une fiction bien tournée. Un seul mot mal choisi peut orienter toute la réponse. Comprendre cela, c’est déjà se protéger.

La majorité des erreurs proviennent non pas de l’IA elle-même, mais du prompt que vous lui donnez. C’est pourquoi je vous partage aujourd’hui une vérité simple : le prompt est le siège de votre résultat. Un prompt mal structuré, flou, ou approximatif génèrera systématiquement une réponse imprécise, voire absurde. Et cela n’est pas une question de modèle ou de puissance : nous faisons 1000 tests par an sur ChatGPT, Gemini ou Mistral, avec toujours les mêmes biais quand l’instruction est faible. En revanche, un prompt structuré avec rigueur, selon des règles établies, permet d’éviter une majorité d’erreurs classiques. La méthode de prompt engineering, telle qu’enseignée dans nos formations, transforme totalement les résultats obtenus. L’optimisation de ces requêtes n’est pas un luxe, c’est une nécessité stratégique.

Un prompt mal conçu affiche souvent les mêmes caractéristiques : trop court, trop vague, il attribue un rôle d’expert du sujet à l’IA. Des phrases comme « Peux-tu me dire le budget IA de la France ? » conduisent inévitablement à des digressions approximatives. D’autres prompts, soi-disant miracles, se résument à 3 ou 4 lignes, parfois en tutoyant l’IA ou en lui attribuant un faux rôle : « Imagine que tu es ministre du budget… ». Ces formes sont non seulement inefficaces, mais nuisibles. Ce style de prompt, hélas très répandu sur TikTok, LinkedIn ou YouTube, est à proscrire. Ce qu’il faut, c’est structurer, préciser, exclure l’interprétation. Un bon prompt exige un balisage lexical, des restrictions précises, des exemples encadrants. C’est à ce prix que ChatGPT devient un outil fiable.

Voici les 7 instructions qui changent tout :

1. Exiger l’exactitude des faits ;

2. Demander vérification des sources ;

3. Interdire toute supposition ;

4. Écarter les généralisations ;

5. Bannir les inventions ;

6. Restreindre les références aux documents joints ou précisés ;

7. Demander transparence sur les choix faits par l’IA.

Intégrées aux prompts à usage professionnel — et les résultats changent radicalement. Sans ces règles, on s’expose à des réponses floues mélangeant différents articles, rapports, dates. Avec ces règles, vous forcez ChatGPT à analyser, segmenter, et expliquer pourquoi il choisit telle ou telle réponse. Ce protocole permet notamment de différencier « budget annoncé » et « budget réellement voté ». Une nuance qui change tout pour un dirigeant.

Je suis effaré par la quantité de contenus médiocres diffusés en ligne par des auto-proclamés experts IA. Leur méthode ? Fournir des listes de prompts de 3 à 10 lignes, publiés sans test, sans contexte métier, et souvent en contradiction avec les règles mêmes du fonctionnement des LLM. Ils vous disent « il suffit de donner un rôle à l’IA », ou « attache ton PDF et demande-lui », comme si l’outil était magique. Résultat : vos commerciaux, vos rédacteurs, vos marketers obtiennent des contenus insipides, redondants, parfois erronés – et vous perdez en crédibilité. Ces prompts font perdre du temps, du budget, et propagent l’impression que l’IA ne vaut rien. La réalité est toute autre, mais elle exige rigueur, pédagogie et méthode. Seule une discipline documentaire vous apportera performance.

Je recommande la méthode DOMPTER, qui structure tout prompt autour des 7 couches d’information dont l’IA a besoin pour fonctionner. Cette méthode a été conçue pour contrer précisément les tendances actuelles d’hallucination des IA génératives. Elle impose une syntaxe claire, l’usage de délimiteurs, l’instruction de non-invention et, surtout, le questionnement croisé des réponses. Lors de nos tests, cette méthode a réduit les erreurs de 70 % à moins de 10 %. En particulier, elle s’avère redoutable pour automatiser la création de contenus SEO à fort volume, puisque chaque information est vérifiée pas à pas. C’est une méthode robuste, reproductible, qui transforme chaque utilisateur en analyste assisté par IA.

Optimiser l’usage de prompts pour ChatGPT ne relève ni du hasard ni de l’intuition ; c’est un véritable levier stratégique, à condition d’y appliquer rigueur et méthode. Je l’ai constaté sur le terrain : les professionnels qui adoptent une posture structurée gagnent en précision, en impact et en créativité. C’est pourquoi je vous encourage à investir dans une démarche éclairée − comme la formation « automatiser ChatGPT » − pour éviter les raccourcis inefficaces. En clair, il ne suffit plus de « parler à l’IA », il faut penser, concevoir et calibrer vos interactions. Ainsi, vous aurez en main un outil réellement puissant, au service d’objectifs ambitieux.

La première chose que je souligne toujours, c’est que ChatGPT ne comprend pas ce qu’il dit. Il génère des réponses en calculant ce qui est statistiquement le plus probable, pas ce qui est factuellement exact. C’est ce fonctionnement probabiliste qui provoque des erreurs, notamment quand on lui demande des données précises comme un budget ou une loi votée. Dans l’affaire du budget IA 2024, par exemple, ChatGPT sort une valeur de 5 milliards d’euros, alors que le vrai montant est de 602 millions. Pourquoi ? Parce qu’il extrapole d’après des mots-clés comme « France 2030 ». Voilà l’importance d’un prompt rigoureux : sans structure, l’IA divague.

Ah, la clé est là ! Les erreurs de ChatGPT naissent à 90 % de prompts flous, trop courts ou mal formulés. Ce que je recommande, c’est la méthode DOMPTER : elle articule le prompt autour de 7 principes comme la délimitation du sujet, l’objectif clair, ou encore la limitation des généralisations. Je n’écris jamais une demande professionnelle sans demander l’exactitude, la transparence sur les choix faits, et l’interdiction d’invention. Cette discipline transforme littéralement la qualité des résultats, surtout si vous cherchez à automatiser ChatGPT dans des processus à fort enjeu, comme le contenu SEO, la veille réglementaire ou la rédaction de rapports confidentiels.

Rien de pire qu’un prompt style “Imagine que tu es ministre et dis-moi…”. Ce type de formulation, pourtant répandu sur TikTok et LinkedIn, conduit à ce qu’on appelle des hallucinations IA. ChatGPT s’empare alors du rôle fictif pour remplir les blancs par pure invention. Les prompts évasifs et les formules de politesse, les prompts qui confient à l’IA la responsabilité de trouver la méthode, déroutent l’IA et génèrent du contenu arbitraire. Pour éviter cela, j’enseigne à tous mes clients — notamment en formation IA et ChatGPT pour les pros — à baliser précisément les demandes, interdire les suppositions, et cadrer chaque point. Cela change absolument tout

Je le dis sans détour : investir dans le prompt engineering, c’est gagner en levier stratégique. Ce n’est pas un gadget pour geek, mais une compétence métier à part entière — elle affecte directement la qualité de l’information, la cohérence des contenus, et in fine, la prise de décision. J’ai vu des dirigeants commettre des erreurs coûteuses pour avoir cru une info générée sans contrôle par ChatGPT. À l’inverse, ceux qui appliquent une méthode de prompt structuré obtiennent des documents fiables, exploitables et même juridiquement solides. Quand on veut créer du contenu avec ChatGPT, ce n’est pas la puissance du modèle qui prime, mais la finesse de l’instruction.

La première erreur, c’est de croire que l’IA “sait” ou “comprend”. Ensuite, c’est de la solliciter à l’intuition, sans méthode. Enfin, c’est d’utiliser des prompts simplistes qu’on trouve en ligne sans les adapter à sa problématique. Pour travailler efficacement avec ChatGPT, il ne faut pas seulement “poser une question” : il faut spécifier, cadencer, illustrer. Personnellement, je ne valide jamais un prompt sans y inclure une vérification des sources ou sans restreindre l’outil aux documents joints. C’est particulièrement utile quand on veut générer du contenu IA fiable pour des projets professionnels, en SEO notamment. La rigueur est votre meilleure alliée.